Neuronale Netze: Das Gehirn der KI in 10 Minuten verstehen

Große Sprachmodelle: So versteht ein KI-Modell unsere Sprache

Der Tokenizer: Wie KI-Modelle Texte in Zahlen übersetzen

Embeddings: Wie KI die Bedeutung von Wörtern versteht

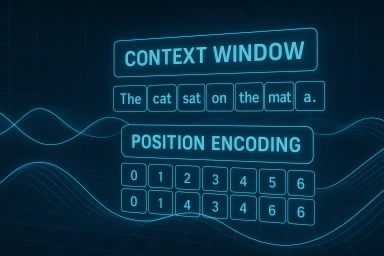

Kontextfenster & Positionskodierung im Transformer

Self-Attention – das Herzstück moderner KI

Self-Attention entschlüsselt – wie Transformer wirklich denken

© 2025 Oskar Kohler. Alle Rechte vorbehalten.Hinweis: Der Text wurde manuell vom Autor verfasst. Stilistische Optimierungen, Übersetzungen sowie einzelne Tabellen, Diagramme und Abbildungen wurden mit Unterstützung von KI-Tools vorgenommen.